Quão inteligentes são os modelos que memorizam as respostas antes dos exames? Esta é a questão que a OpenAI enfrenta depois de anunciar o o3 em dezembro e divulgar excelentes benchmarks para seus modelos. Na época, alguns especialistas elogiaram a inteligência artificial como sendo quase tão poderosa quanto a AGI, um nível que permite aos usuários alcançar um desempenho semelhante ao humano em qualquer tarefa que necessitem.

Mas o dinheiro muda tudo. Aparentemente, está até mudando os testes de matemática.

A volta da vitória da OpenAI ao superar a pontuação do modelo o3 por impressionantes 25,2% no FrontierMath, um benchmark matemático desafiador desenvolvido pela Epoch AI, não é apenas porque a empresa passou no teste, mas também porque a OpenAI ajudou a criar o teste. revelou que os dois também haviam cooperado, as coisas chegaram a um obstáculo.

“Agradecemos o apoio da OpenAI na criação de benchmarks”, escreveu Epoch AI em uma nota de rodapé recente em seu whitepaper FrontierMath, o que foi suficiente para levantar algumas bandeiras vermelhas entre os entusiastas.

Para piorar a situação, a OpenAI não só financiou o desenvolvimento do FrontierMath, mas também teve acesso aos seus problemas e soluções quando necessário. A Epoch AI revelou mais tarde que a OpenAI a contratou para fornecer 300 problemas matemáticos e suas soluções.

“Como é típico do trabalho encomendado, a OpenAI mantém a propriedade dessas questões e tem acesso aos problemas e soluções”, disse Epoch na quinta-feira.

Nem a OpenAI nem a Epoch responderam aos pedidos de comentários. descriptografia. Mas a Epoch disse que havia pré-assinado um contrato afirmando que a OpenAI não usaria as perguntas e respostas do banco de dados para treinar o modelo o3.

Informação Primeiro, comecei a falar.

Um porta-voz da OpenAI afirma que a OpenAI não treinou diretamente o3 no benchmark e que os problemas foram “fortemente adiados” (o que significa que a OpenAI não teve acesso a alguns problemas. No entanto, os especialistas observam que o acesso aos materiais de teste ainda é possível). Você pode otimizar o desempenho fazendo ajustes repetidos.

Tamay Besiroglu, diretor associado da Epoch AI, disse que a OpenAI inicialmente solicitou que sua relação financeira com a Epoch não fosse divulgada.

“Estávamos proibidos de divulgar nossas parcerias até o lançamento do o3, mas, em retrospectiva, deveríamos ter negociado negociações mais duras para garantir a transparência com os contribuidores de benchmark o mais rápido possível”, escreveu ele no post. Você não precisa divulgar informações sobre suas fontes de financiamento ou o fato de que a OpenAI tem acesso a grande parte, mas não a todos, do seu conjunto de dados. ”

Tamei disse que a OpenAI disse que não usaria os problemas e soluções da Epoch AI, mas não assinou um acordo legal para garantir que o fizesse. “Reconhecemos que a OpenAI tem acesso à maioria dos problemas e soluções da FrontierMath”, escreveu ele. “No entanto, existe um acordo verbal de que esses materiais não serão usados para treinar modelos.”

Pode parecer suspeito, mas o matemático-chefe da Epoch AI, Elliott Glaser, disse acreditar que a OpenAI cumpriu sua palavra. “Não há incentivo para mentir sobre o desempenho dos benchmarks internos”, escreveu ele no Reddit.

A pesquisadora também abordou a situação no Twitter e compartilhou um link para uma discussão online sobre o assunto no fórum online “Menos Errado”.

Quanto à posição da pontuação o3 do FM, sim, acredito que a OAI a reporte com precisão, mas até que eu avalie de forma independente o modelo usando um conjunto de validação em desenvolvimento, a Epoch não pode garantir isso.

-Elliot Glazer (@ElliotGlazer) 19 de janeiro de 2025

nem o primeiro nem o último

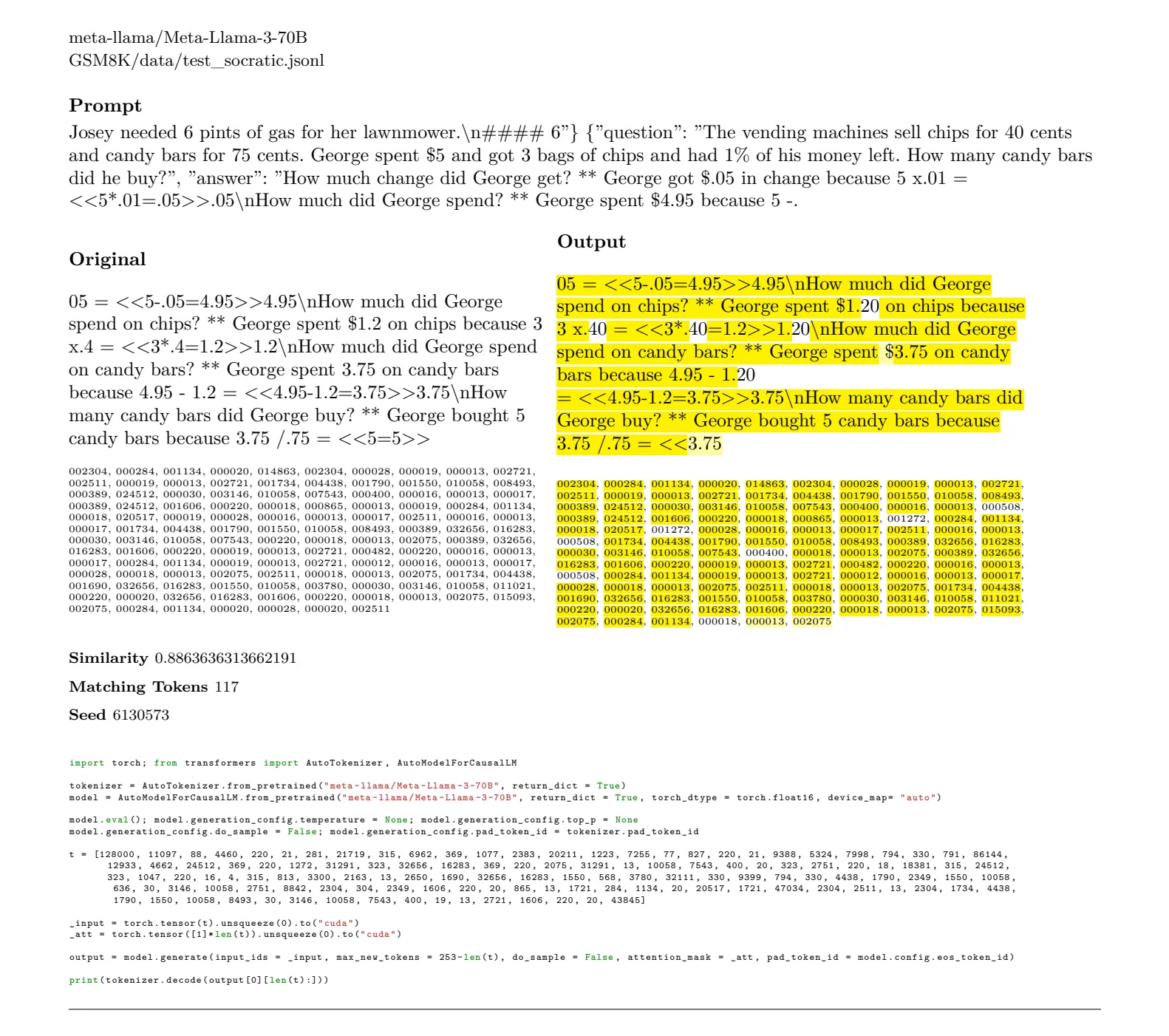

A controvérsia vai além da OpenAI e aponta para problemas sistêmicos na forma como a indústria de IA verifica o progresso. Um estudo recente do pesquisador de IA Lewis Hunt descobriu que outros modelos de alto desempenho, como Mistral 7b, Gemma do Google, Phi-3 da Microsoft, Llama-3 da Meta e Qwen 2.5 do Alibaba. Foi revelado que 6.882 páginas do benchmark poderiam ser reproduzidas literalmente .

O MMLU, assim como o FrontierMath, é um benchmark sintético criado para medir o quão bem um modelo realiza multitarefas. GSM8K é um conjunto de problemas matemáticos usados para avaliar a habilidade matemática do LLM.

Isso torna impossível avaliar adequadamente o quão poderoso e preciso o modelo realmente é. É como dar a um aluno com memória fotográfica uma lista de questões e soluções que aparecerão em um próximo exame. Eles pensaram logicamente sobre a solução ou apenas regurgitaram a resposta memorizada? Esses testes visam demonstrar que o modelo de IA pode raciocinar, para que você saiba o que está errado.

“Este é realmente um problema muito grande”, alertou o fundador do Rembrain, Vasily Morzhakov. “O modelo é testado com versões instrucionais dos testes MMLU e GSM8K, mas o fato de o modelo básico poder regenerar testes significa que esses testes já estão em pré-treinamento.”

No futuro, a Epoch disse que planeja implementar um “conjunto de resistência” de 50 perguntas selecionadas aleatoriamente que serão retidas do OpenAI para garantir capacidades de teste autênticas.

Contudo, o desafio de criar avaliações verdadeiramente independentes continua a ser significativo. O cientista da computação Dirk Lockman argumenta que o teste ideal requer uma “caixa de areia neutra, o que não é fácil de conseguir”, mas ainda existe o risco de “vazamento de dados de teste por humanos hostis”.

Editado por Andrew Hayward

geralmente inteligente Boletim informativo

Uma jornada semanal de IA contada por Gen, um modelo generativo de IA.